Et si une simple panne de serveur suffisait à paralyser toute votre entreprise ? Commandes bloquées, applications inaccessibles, perte de données… Une défaillance technique peut coûter en quelques minutes ce que des mois d’efforts ont permis de construire.

Aujourd’hui, les DSI et dirigeants savent que la question n’est plus si un incident se produira, mais quand. Sans redondance, sans plan de basculement ni procédures de restauration, une entreprise s’expose à des pertes majeures et durables. C’est précisément l’objectif d’une architecture haute disponibilité : anticiper les pannes et garantir la continuité de service.

Dans cet article, découvrez comment mettre en place une véritable infrastructure de haute disponibilité : de la gestion des ressources au déploiement de clusters, en passant par la récupération de données et les bonnes pratiques de supervision.

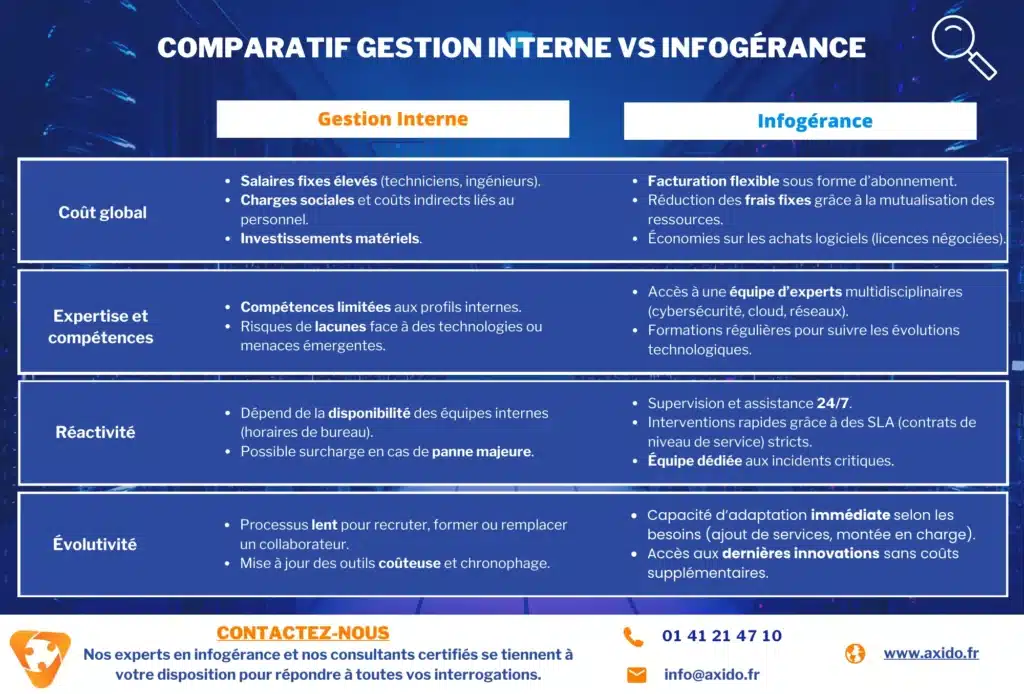

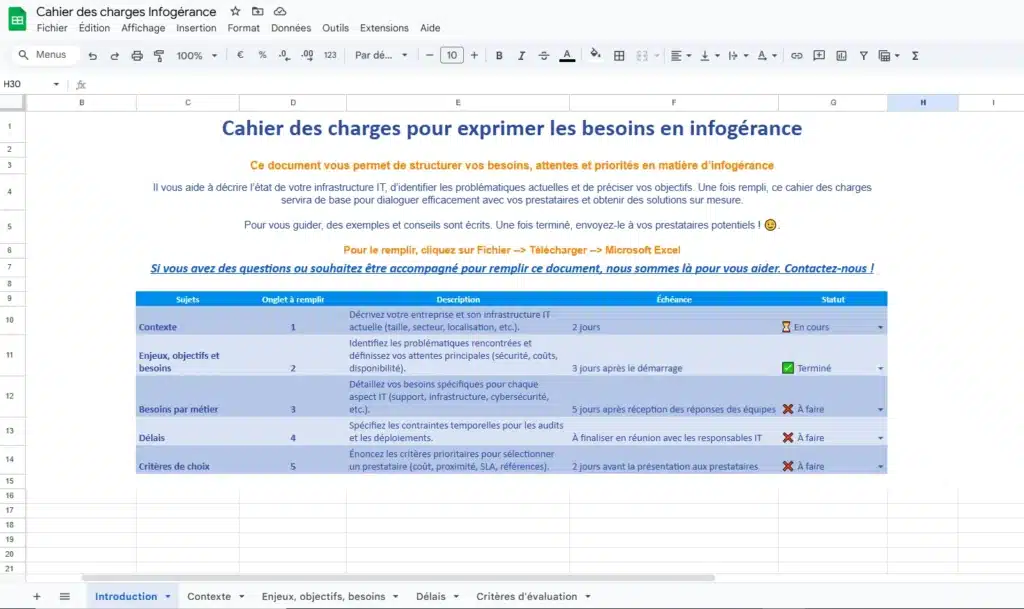

✅ Découvrez les différences clés entre la gestion informatique en interne et l’infogérance, sur des critères comme la sécurité, la réactivité et les coûts.

✅ Ce tableau vous aide à identifier quelle solution est la plus adaptée à votre entreprise selon vos besoins actuels et vos objectifs à long terme.

Pourquoi l’indisponibilité informatique coûte si cher aux entreprises ?

Les interruptions de service, même courtes, peuvent avoir des conséquences bien plus lourdes qu’on ne l’imagine. Derrière une panne se cachent non seulement des pertes financières directes, mais aussi un impact durable sur la réputation de l’entreprise.

Perte financière et interruption d’activité

Chaque minute d’arrêt peut se traduire par des milliers d’euros perdus. Selon une étude de Gartner, le coût moyen d’une heure d’indisponibilité est estimé à 276 000 €, un chiffre qui grimpe encore dans les secteurs critiques comme la finance ou le e-commerce.

Pour une PME, cela se traduit souvent par une chute de productivité immédiate : équipes bloquées, commandes non traitées, clients en attente. Un poste de travail indisponible peut sembler anodin, mais multiplié par des dizaines ou centaines de collaborateurs, le coût devient rapidement colossal.

C’est aussi pour cette raison que de nombreuses entreprises choisissent de souscrire un contrat d’infogérance : déléguer la surveillance et la maintenance à un prestataire spécialisé permet de limiter les interruptions et de sécuriser la disponibilité informatique au quotidien.

Atteinte à l’image et à la confiance des clients

Au-delà de la perte immédiate, chaque incident d’indisponibilité fragilise la relation de confiance avec les clients. Un site d’e-commerce qui tombe en pleine période de soldes, une plateforme SaaS inaccessible plusieurs heures ou encore une défaillance dans un système de paiement peuvent laisser une empreinte durable. Dans un contexte de forte concurrence, il suffit parfois d’une seule indisponibilité pour que les utilisateurs se tournent vers un concurrent perçu comme plus fiable.

Une minute de panne peut coûter des milliers d’euros, mais la perte de confiance d’un client peut coûter encore plus cher. La haute disponibilité n’est pas seulement un enjeu technique, c’est avant tout un sujet de résilience business.

Frédéric André, Conseiller en intégration de solutions IT, Cloud & Cybersécurité chez Axido

Ici encore, l’accompagnement d’une entreprise de maintenance informatique ou d’un prestataire d’infogérance peut faire la différence. En anticipant les incidents grâce à une meilleure gestion du risque informatique, l’organisation protège non seulement son chiffre d’affaires, mais aussi son image de marque.

Axido, un prestataire informatique certifié et reconnu

Nos certifications et notre expertise font d’Axido un partenaire de confiance pour concevoir et exploiter des architectures haute disponibilité adaptées aux PME et grands comptes.

✅ 30 ans d’expertise en infogérance et infrastructures IT

✅ Support client 24/7 avec SLA garantissant la haute disponibilité

✅ Certifications Microsoft Azure (Solutions Architect & Administrator)

✅ Partenaire Microsoft Cloud Solutions reconnu

✅ Méthodologie ITIL et conformité aux normes de sécurité (ISO/27001)

Quelles solutions techniques garantissent la haute disponibilité ?

Mettre en place une infrastructure réellement résiliente ne se résume pas à multiplier les serveurs. C’est un ensemble cohérent de technologies et de bonnes pratiques qui, combinées, réduisent drastiquement les risques de panne. Voici les principaux leviers techniques utilisés par les entreprises pour assurer une disponibilité continue de leurs systèmes.

Pour bien comprendre, voici ce que représentent les différents niveaux d’uptime souvent mentionnés dans les contrats de haute disponibilité :

| Niveau d’uptime (SLA) | Panne max / mois (30 j) | Panne max / an (365 j) |

|---|---|---|

| 99,9 % | ≈ 43 min 12 s | ≈ 8 h 45 min 36 s |

| 99,99 % | ≈ 4 min 19 s | ≈ 52 min 34 s |

| 99,999 % | ≈ 25,9 s | ≈ 5 min 15 s |

Beaucoup d’entreprises pensent qu’un SLA de 99,9 % suffit. En réalité, la différence entre 99,9 % et 99,99 % représente presque 8 heures d’arrêt évitées par an. Dans un environnement e-commerce ou SaaS, ces heures peuvent représenter des centaines de milliers d’euros de chiffre d’affaires sauvegardé.

Frédéric André, Conseiller en intégration de solutions IT, Cloud & Cybersécurité chez Axido

Redondance et tolérance aux pannes

Le principe est simple : éviter le point de défaillance unique. En doublant les composants critiques (serveurs, alimentation, stockage, connexions réseau), une panne matérielle n’entraîne pas l’arrêt du service. C’est ce qu’on appelle la tolérance aux pannes, un pilier incontournable de la haute disponibilité.

Par exemple, une entreprise peut installer deux routeurs reliés à des opérateurs différents. Si l’un tombe, l’autre prend automatiquement le relais. Cette approche est souvent incluse dans un contrat d’infogérance informatique ou de services managés, où le prestataire s’engage à maintenir cette redondance.

Clustering et load balancing

Le clustering consiste à regrouper plusieurs serveurs qui travaillent comme un seul. Si l’un échoue, les autres continuent à traiter les requêtes. Le load balancing (répartition de charge) permet, lui, de distribuer intelligemment les connexions entre plusieurs serveurs, évitant ainsi les surcharges.

C’est un élément clé pour les applications critiques : un site d’e-commerce avec des milliers de visiteurs simultanés, une solution SaaS ou encore une plateforme de téléphonie IP. Grâce au load balancing, même en cas de pic d’activité, les utilisateurs continuent d’accéder au service sans interruption.

📌 Cas client – E-commerce

Une enseigne e-commerce que nous accompagnons subissait régulièrement des interruptions lors des périodes de soldes, avec jusqu’à 20 minutes d’arrêt par pic de charge. Après mise en place d’un cluster multi-serveurs et d’un load balancer, le site a atteint une disponibilité de 99,99 %, soit moins d’une heure de coupure par an.

Résultat : +15 % de chiffre d’affaires sur la période promotionnelle suivante.

Réplication et sauvegarde continue

La donnée est au cœur de toute activité. Pour la protéger, deux mécanismes se complètent :

La réplication, qui duplique les données en temps réel sur plusieurs serveurs ou sites.

La sauvegarde continue, qui permet de restaurer rapidement l’information en cas de corruption ou de perte.

Plusieurs études citées dans le secteur de la cybersécurité soulignent l’impact critique d’une perte de données. Selon la Contingency Planning & Strategic Research Corp., près de 80 % des entreprises qui subissent une perte informatique majeure ferment dans les 12 mois. Ce chiffre, souvent repris dans les rapports de l’ANSSI ou de cabinets comme Gartner, montre combien la mise en place d’une stratégie de sauvegarde et d’infogérance haute disponibilité est vitale.

C’est pourquoi de nombreuses PME optent pour une infogérance informatique PME incluant des solutions de sauvegarde automatisées et des outils comme GLPI pour suivre leurs actifs.

Cloud, multi-cloud et solutions hybrides

Le cloud a profondément transformé l’approche de la haute disponibilité. Là où une infrastructure traditionnelle nécessitait d’investir massivement dans des serveurs, du stockage et des composants redondants, les services cloud offrent aujourd’hui une alternative plus flexible et scalable.

Cloud public : il permet aux entreprises d’accéder à des ressources mutualisées, prêtes à l’emploi, et de payer uniquement à l’usage. Les processus de basculement et de récupération sont intégrés par défaut dans les offres des grands acteurs (AWS, Azure, Google Cloud, OVHcloud).

Multi-cloud : consiste à répartir ses applications et ses data entre plusieurs fournisseurs afin d’éviter une dépendance unique. Cette stratégie limite l’impact d’une panne majeure sur un seul fournisseur.

Cloud hybride : combine un datacenter privé (où l’entreprise garde un contrôle complet sur ses données sensibles) et un cloud public pour la souplesse et l’élasticité.

Par exemple, lors de la panne mondiale d’AWS en décembre 2021, des milliers de services ont été paralysés pendant plusieurs heures. Les entreprises qui avaient mis en place une stratégie multi-cloud ont pu assurer la continuité de leurs systèmes et maintenir leurs services critiques.

Monitoring et supervision proactive

Mettre en place une architecture haute disponibilité sans supervision, c’est comme conduire une voiture de course sans tableau de bord. Les entreprises doivent surveiller en temps réel l’état de leur infrastructure : serveurs, bases de données, réseaux, applications.

Des outils de surveillance réseau informatique analysent en continu la performance et alertent en cas d’anomalie, souvent avant que l’utilisateur ne s’en rende compte. Cette supervision inclut aussi des éléments connexes comme le wifi entreprise, la téléphonie IP ou les applications métiers.

En pratique, un prestataire en infogérance informatique configure des alertes, des scénarios de basculement automatique et des tests réguliers de continuité de service. Résultat : moins d’incidents critiques et une meilleure maîtrise de la gestion du risque informatique.

Quels secteurs exigent une disponibilité 24/7 ?

Certaines activités ne peuvent tout simplement pas se permettre une coupure, même de quelques minutes. La haute disponibilité n’y est plus un luxe, mais une condition de survie. Voici quatre exemples où la continuité de service est vitale.

Banque et finance : continuité des transactions

Dans le secteur bancaire, une panne ne se traduit pas seulement par une perte financière, mais aussi par une atteinte à la confiance du public et des régulateurs. Chaque heure d’indisponibilité d’un système de paiement peut coûter entre 6 et 9 millions de dollars aux grandes institutions financières.

Les systèmes de transactions 24/7 exigent donc une infrastructure tolérante aux pannes, souvent gérée via un prestataire d’infogérance spécialisé dans la gestion du risque informatique. Ici, la redondance et le monitoring permanent sont incontournables pour assurer la sécurité et la fluidité des échanges.

E-commerce et SaaS : disponibilité = chiffre d’affaires

Dans le commerce en ligne, chaque seconde compte. Amazon a estimé qu’une panne de une minute pouvait lui coûter plus de 200 000 $ de chiffre d’affaires perdu. Pour une plateforme SaaS, l’équation est similaire : un client qui ne peut pas accéder à son application bascule rapidement vers un concurrent.

Les entreprises de ce secteur misent de plus en plus sur l’infogérance cloud et les services managés, afin d’assurer une performance constante même en période de forte affluence (Black Friday, campagnes marketing, etc.). De la surveillance réseau informatique à l’optimisation du wifi entreprise, chaque maillon de la chaîne est crucial pour garantir une expérience fluide.

Santé : des systèmes vitaux qui ne peuvent pas tomber

Dans les hôpitaux et cliniques, l’indisponibilité n’est pas seulement une question financière : elle peut mettre des vies en danger. Un bloc opératoire qui perd l’accès à ses équipements numériques ou un laboratoire incapable de consulter ses résultats en temps réel peut provoquer des conséquences dramatiques.

Selon l’ANSSI, 70 % des incidents de cybersécurité dans la santé entraînent une indisponibilité temporaire des systèmes critiques. Pour limiter ces risques, les établissements se tournent vers des solutions d’infogérance informatique adaptées, parfois spécifiques comme l’infogérance Mac pour leurs environnements bureautiques. L’objectif est clair : garantir la fiabilité et la continuité des services médicaux.

Industrie et production : garantir la continuité opérationnelle

Une chaîne de production automatisée ne peut pas s’arrêter sans conséquence immédiate. Chaque heure d’arrêt coûte en moyenne 260 000 $ à une entreprise industrielle, selon Aberdeen Research. Dans certains cas, l’arrêt soudain d’une machine peut aussi générer des défauts de sécurité pour les opérateurs.

Pour se prémunir, les industriels investissent dans des solutions de maintenance informatique associées à des systèmes de haute disponibilité, souvent supervisés par une entreprise de maintenance informatique ou un prestataire d’infogérance. La mise en place de plans de reprise et d’architectures hybrides leur permet d’assurer la continuité opérationnelle, même en cas de panne majeure.

Comment mettre en place la haute disponibilité dans son organisation ?

Passer d’une infrastructure traditionnelle à une architecture de haute disponibilité ne se limite pas à multiplier les serveurs ou les composants matériels. C’est une stratégie globale qui combine organisation, bonnes pratiques, technologies adaptées et supervision continue. Voici les étapes clés pour réussir cette transformation et protéger vos données et vos applications critiques.

1. Évaluer les besoins et prioriser les applications

La première étape consiste à analyser vos systèmes et vos processus métier pour identifier les services qui doivent rester accessibles en permanence : ERP, CRM, portail client, messagerie, bases SQL… En d’autres termes, il s’agit de savoir comment mettre en place une architecture haute disponibilité adaptée à vos priorités.

Chaque entreprise doit se poser une question simple : “Quelle est la perte financière ou opérationnelle en cas de panne de ce système ?”

Selon une étude d’IDC, une perte de données ou une indisponibilité de serveur coûte en moyenne 5 600 $ par minute aux grandes entreprises. Pour une PME, ce chiffre peut sembler moindre, mais le risque est proportionnellement plus critique.

2. Définir un niveau de disponibilité et des objectifs mesurables

Une architecture ne peut pas être “100 % disponible”. Il faut donc définir des objectifs réalistes via :

SLA (Service Level Agreement) : niveau de disponibilité garanti par votre prestataire.

RTO (Recovery Time Objective) : temps maximal de récupération après une défaillance.

RPO (Recovery Point Objective) : perte maximale de data tolérable.

Ces indicateurs doivent être intégrés dans le contrat d’infogérance ou dans un devis d’infogérance informatique pour garantir une transparence sur les engagements.

3. Choisir l’architecture et les solutions adaptées

Selon la taille et le budget, plusieurs options s’offrent à vous :

PME : privilégier des solutions cloud et des services d’infogérance informatique PME pour accéder à des technologies avancées sans investissement massif en infrastructure locale.

Grands comptes : mise en place de clusters multi-sites, stockage redondant, réseau multi-opérateurs et virtualisation des machines pour plus de flexibilité.

Environnements spécifiques : certaines entreprises utilisent des postes Linux ou Mac, nécessitant une configuration et un déploiement adaptés via des offres d’infogérance Mac.

Attention : une mauvaise configuration des composants ou un mauvais choix de produits peut créer un faux sentiment de sécurité et fragiliser tout le système.

4. Prévoir un plan de basculement et de secours

La haute disponibilité repose sur la redondance et la capacité de basculement automatique. Cela implique de :

Dupliquer vos serveurs principaux en mode miroir.

Mettre en place des systèmes de secours pour le stockage et le réseau.

Tester régulièrement la restauration et la récupération après panne.

Un plan de secours informatique doit détailler la répartition des ressources, le rôle de chaque équipe et les pratiques à suivre en cas de crise.

5. Mettre en place une supervision proactive et continue

Même avec une excellente infrastructure, une indisponibilité peut survenir sans alerte si vous ne surveillez pas vos performances.

Utilisez des outils capables de configurer des alertes en temps réel.

Surveillez vos systèmes Linux, vos applications SQL, vos serveurs virtuels et vos services cloud.

Analysez les métriques pour détecter les dégradations avant la panne.

Un prestataire d’infogérance peut mettre en place des solutions de surveillance réseau informatique adaptées à votre environnement et assurer une remontée rapide d’incident.

6. Tester, documenter et améliorer en continu

La haute disponibilité est un processus vivant. Les technologies évoluent, vos applications changent, vos besoins en ressources augmentent. C’est pourquoi il est essentiel de :

Réaliser des tests de basculement planifiés (au moins une fois par an).

Mettre à jour les configurations et les plans de restauration.

Documenter chaque panne et chaque reprise de service pour améliorer vos pratiques.

La mise en place d’une infrastructure de haute disponibilité repose sur trois piliers : une analyse claire des besoins, une infrastructure conçue avec les bonnes technologies, et une gestion proactive pour anticiper les défaillances. Bien menée, cette stratégie transforme la disponibilité informatique en avantage concurrentiel, tout en optimisant l’utilisation de vos ressources. En pratique, comprendre la différence entre PRA et PCA et mesurer le coût d’une panne informatique est essentiel pour convaincre la direction d’investir dans la haute disponibilité.

La haute disponibilité ne se résume pas à acheter plus de serveurs. C’est une approche stratégique qui combine architecture, supervision et plan de continuité. Les entreprises qui investissent dans cette démarche transforment un risque informatique en avantage compétitif durable.

Frédéric André, Conseiller en intégration de solutions IT, Cloud & Cybersécurité chez Axido

FAQ sur la haute disponibilité informatique

Quelle est la différence entre haute disponibilité et tolérance aux pannes ?

La haute disponibilité vise à minimiser les interruptions de service dans le quotidien. La tolérance aux pannes est une caractéristique technique qui permet à un composant ou un système de continuer à fonctionner malgré une défaillance partielle (mode dégradé). Les deux sont complémentaires mais distincts.

Quand faut-il privilégier un PRA plutôt qu’une architecture haute disponibilité ?

L’architecture haute disponibilité prévient les interruptions à un niveau applicatif/infra. Le PRA est un plan de secours pour restaurer en cas de sinistre majeur (ex : perte totale d’un datacenter). On choisit un PRA quand le coût de la redondance permanente devient trop élevé ou pour couvrir des scénarios extrêmes.

Quel niveau d’uptime est réaliste pour une PME ?

Pour de nombreuses PME, viser 99,9 % est souvent un bon compromis entre coût et fiabilité. Cela correspond à environ 8 h 45 de panne par an, ce qui reste acceptable pour la majorité des activités. Les entreprises plus sensibles (e-commerce, santé, finance) optent souvent pour 99,99 %, soit moins d’1 heure de coupure par an.

Le multi-cloud garantit-il une meilleure haute disponibilité ?

Le multi-cloud réduit le risque de panne d’un fournisseur unique, mais il introduit de la complexité (interopérabilité, latence, coût). Il faut le dominer techniquement pour que ce gain en disponibilité soit réel.

Comment tester une architecture haute disponibilité sans impacter les utilisateurs ?

On peut procéder à des tests de bascule (failover) en environnement homologué ou pendant des fenêtres planifiées, en simulant des pannes (couper une VM, un lien réseau) et en observant la rapidité de reprise. En pratique, un prestataire en infogérance peut orchestrer ces tests régulièrement pour garantir un SLA conforme aux attentes.